近日,2025年AAAI国际人工智能顶级会议(AAAI Conference on Artificial Intelligence. AAAI)录用结果公布,我校自动化与信息工程学院刘龙教授课题组论文《Adaptive Dual Guidance Knowledge Distillation》被正式录用,西安理工大学自动化与信息工程学院为唯一署名单位,第一作者为本校博士研究生李通,通讯作者为刘龙教授。刘龙教授课题组长期从事机器学习与机器视觉领域的研究,该项研究成果的发表标志着该团队的相关研究工作得到了国际人工智能领域学术同行的认可。

AAAI是国际人工智能领域最顶级的盛会之一,也是中国计算机学会 (CCF) 推荐的人工智能领域的A类国际学术会议。2025年,AAAI主办地为美国费城,投稿量12,957篇,录用文章3032篇,录用率约为23.4%,被录用的论文主题涵盖了人工智能领域的各项前沿工作。

知识蒸馏作为一种从大型教师模型向轻量级学生模型迁移知识、提升性能的学习范式被广泛用于模型压缩领域。随着知识蒸馏的发展,这一学习范式被逐渐扩展到各种深度学习任务和场景中,包括计算机视觉、自然语言处理、以及推荐系统等。然而,随着教师模型与学生模型之间差异的增加,现有蒸馏算法往往难以有效提高学生模型的性能,造成容量沟壑问题。为解决这一问题,自适应蒸馏被提出。但目前的自适应蒸馏算法存在两点不足:1. 教师知识与学生表征能力不兼容:现有方法仅通过简单地降低教师网络性能或调整其参数空间使知识易于学习,无法使其与学生的表征能力相兼容,因此在缓解容量沟壑问题时效果有限。2.准确知识表征的缺失:现有自适应蒸馏算法会不可避免地丢失准确的知识表征,不利于学生模型取得与教师模型相近的性能。

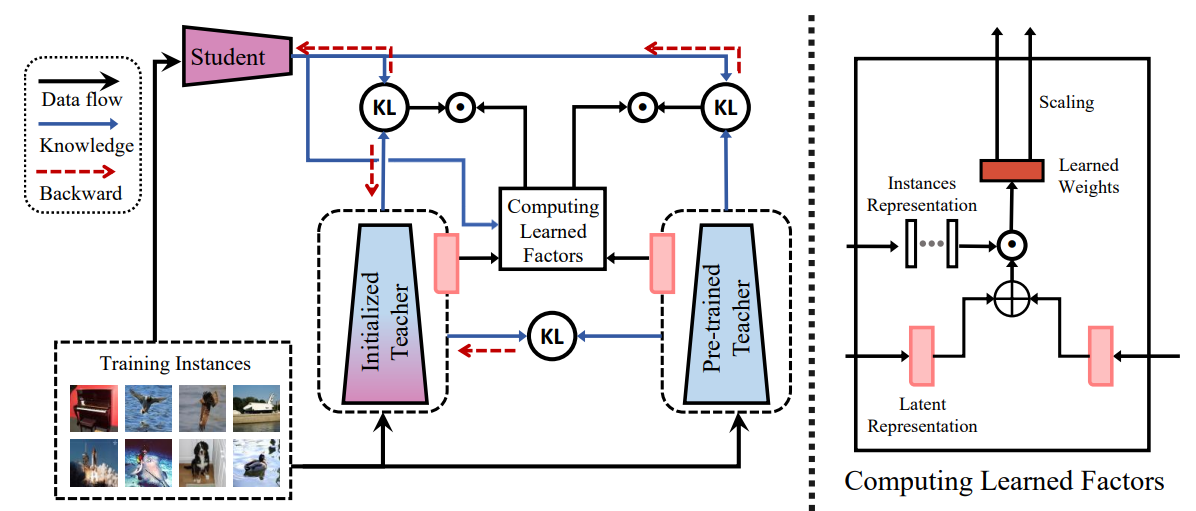

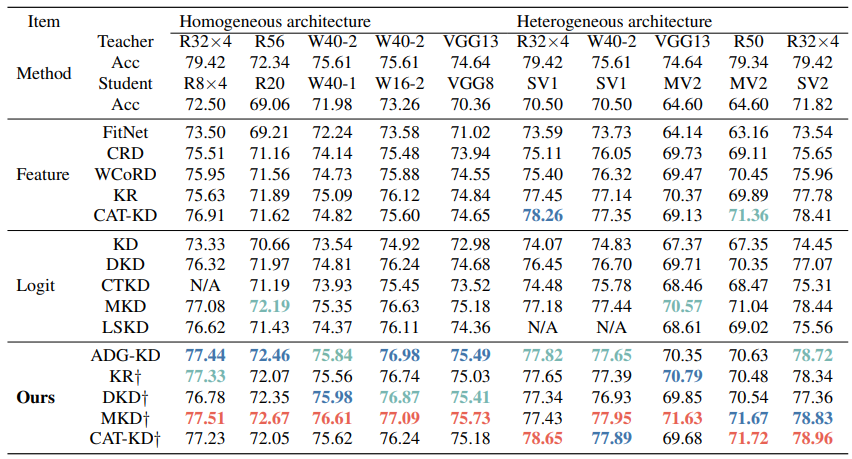

为解决上述问题,本论文提出了一种自适应双重引导知识蒸馏 (Adaptive Dual Guidance Knowledge Distillation, ADG-KD)。ADG-KD在保留预训练教师的基础上,额外引入了一个与预训练教师同构的初始化教师模型。该初始化教师模型在预训练教师模型与学生模型的双向监督下进行优化,从而构建出教师网络的双向优化路线。在蒸馏过程中,学生模型在预训练教师模型及其双向优化路线的自适应双重引导下进行优化,以学习到准确的知识表征以及与其表征能力相兼容的知识序列。广泛的实验表明,本论文提出的方法能够有效解决容量沟壑问题,并促使学生模型取得与教师模型相近的性能。